Más del 60% de las empresas ya reconoce que la confianza en la inteligencia artificial es clave para su éxito a largo plazo. En un mundo donde las decisiones automatizadas influyen cada vez más en la vida y en los negocios, pensar solo en las capacidades técnicas ya no es suficiente. Descubrirás por qué la IA responsable se ha convertido en un pilar fundamental no solo para cumplir con la ley, sino para construir soluciones tecnológicas que generen impacto positivo y eviten riesgos tanto para las personas como para las organizaciones.

Tabla de Contenidos

- Definición y principios de la ia responsable

- Categorías y modelos de ia ética y responsable

- Aplicaciones empresariales de la ia responsable

- Marco normativo y regulaciones internacionales

- Riesgos, retos y responsabilidades para empresas

Puntos Clave

| Punto | Detalles |

|---|---|

| Enfoque ético de la IA | La IA responsable prioriza el bienestar humano y social, integrando consideraciones éticas desde las etapas iniciales del diseño. |

| Principios fundamentales | La IA debe ser transparente, equitativa, proteger la privacidad y contar con mecanismos de supervisión para evitar sesgos y garantizar la rendición de cuentas. |

| Importancia de la gobernanza | Desarrollar marcos de gobernanza es esencial para mitigar riesgos, asegurando que la implementación de IA cumpla con estándares éticos y sociales. |

| Responsabilidad y sostenibilidad | Las empresas deben alinear la tecnología con principios éticos, creando una cultura organizacional donde la innovación respete la dignidad y derechos humanos. |

Definición y principios de la IA responsable

La inteligencia artificial responsable representa un enfoque ético y consciente para el desarrollo y despliegue de tecnologías de inteligencia artificial que prioriza el bienestar humano y social. A diferencia de los enfoques tradicionales que solo se centran en capacidades técnicas, la IA responsable integra consideraciones éticas, de seguridad y de impacto social desde las primeras etapas de diseño.

Los principios fundamentales de la IA responsable incluyen transparencia, equidad, privacidad y accountability. Estos principios buscan garantizar que los sistemas de inteligencia artificial:

- No discriminen o reproduzcan sesgos históricos

- Protejan la privacidad de los individuos

- Sean explicables y comprensibles para los usuarios

- Tengan mecanismos claros de supervisión y control

Evaluar los riesgos de IA en empresas se ha convertido en un componente crítico para las organizaciones modernas. Las empresas deben desarrollar marcos de gobernanza que no solo cumplan con regulaciones, sino que también promuevan una cultura de responsabilidad tecnológica. Esto implica crear sistemas que sean transparentes, que puedan ser auditados y que tengan límites éticos claramente definidos.

En esencia, la IA responsable no es solo una opción estratégica, sino un imperativo ético para cualquier organización que busque implementar tecnologías de inteligencia artificial de manera sostenible y respetuosa. Requiere un compromiso continuo de evaluar no solo lo que la tecnología puede hacer, sino lo que debería hacer para generar valor real y positivo para la sociedad.

Categorías y modelos de IA ética y responsable

La IA ética y responsable se estructura en diferentes categorías que reflejan diversos enfoques para garantizar un desarrollo tecnológico seguro y respetuoso. Estas categorías no son simplemente marcos teóricos, sino herramientas prácticas para implementar sistemas de inteligencia artificial que protejan los derechos y el bienestar humano.

Las principales categorías de modelos de IA responsable incluyen:

- IA centrada en el ser humano: Prioriza el impacto directo en las personas

- IA transparente: Garantiza la explicabilidad de los procesos de decisión

- IA inclusiva: Diseñada para reducir sesgos y discriminación

- IA con supervisión ética: Incorpora mecanismos de control y evaluación continua

Modelos de lenguaje representan un área crítica donde estos principios éticos se vuelven fundamentales. La implementación de estos modelos requiere un análisis profundo de su potencial impacto social, considerando no solo sus capacidades técnicas, sino también sus posibles consecuencias no intencionadas.

El objetivo final de estas categorías es crear sistemas de inteligencia artificial que no solo sean tecnológicamente avanzados, sino también socialmente responsables. Cada modelo debe ser evaluado bajo criterios que van más allá del rendimiento computacional, incorporando consideraciones éticas, de privacidad y de justicia como componentes esenciales de su diseño y funcionamiento.

Aplicaciones empresariales de la IA responsable

La inteligencia artificial responsable se está convirtiendo en un componente estratégico fundamental para las empresas modernas, transformando la manera en que las organizaciones abordan la innovación tecnológica con un enfoque ético y consciente. Lejos de ser solo una tendencia pasajera, representa una revolución en la forma de implementar soluciones tecnológicas que equilibran el rendimiento con los valores humanos.

Según PwC, es crucial incorporar prácticas de IA responsable en cada etapa del proceso de implementación, desde la planificación hasta el monitoreo, para mitigar riesgos y asegurar una trayectoria sostenible. Las aplicaciones empresariales más relevantes incluyen:

- Sistemas de contratación sin sesgos

- Análisis predictivo con consideraciones éticas

- Atención al cliente personalizada y empática

- Optimización de procesos con supervisión humana

- Toma de decisiones transparente y explicable

Aplicaciones Empresariales de la IA demuestran que la implementación responsable no solo mitiga riesgos, sino que también genera valor real para las organizaciones. Como IBM destaca, el objetivo es alinear estas tecnologías con valores éticos y legales, promoviendo la confianza en las soluciones de inteligencia artificial.

El futuro de la IA empresarial no se trata únicamente de capacidad tecnológica, sino de crear sistemas que respeten la dignidad humana, garanticen la privacidad y promuevan la equidad. Las empresas que adopten este enfoque no solo cumplirán con estándares éticos, sino que obtendrán una ventaja competitiva significativa en un mundo cada vez más consciente de los impactos sociales de la tecnología.

Marco normativo y regulaciones internacionales

El marco normativo internacional para la inteligencia artificial representa un esfuerzo global sin precedentes para establecer directrices que garanticen el desarrollo ético y responsable de tecnologías cada vez más complejas e influyentes. Este ecosistema regulatorio busca equilibrar la innovación tecnológica con la protección de los derechos fundamentales de los individuos.

Según UNESCO, la recomendación internacional sobre ética de la IA establece principios fundamentales como:

- Proporcionalidad en el desarrollo tecnológico

- Garantía de seguridad

- Promoción de la equidad

- Prevención de la discriminación

- Protección de los derechos humanos

Ventajas De La IA En Empresas muestra cómo estas regulaciones no son restricciones, sino oportunidades para desarrollar tecnologías más inclusivas. Como Microsoft detalla, los principios de IA responsable incluyen elementos críticos como equidad, confiabilidad, privacidad, inclusión, transparencia y responsabilidad.

El panorama regulatorio actual no solo busca establecer límites, sino crear un marco que permita la innovación responsable. Las empresas que comprendan y se adelanten a estas regulaciones no solo cumplirán con estándares legales, sino que desarrollarán ventajas competitivas basadas en la confianza y la transparencia tecnológica.

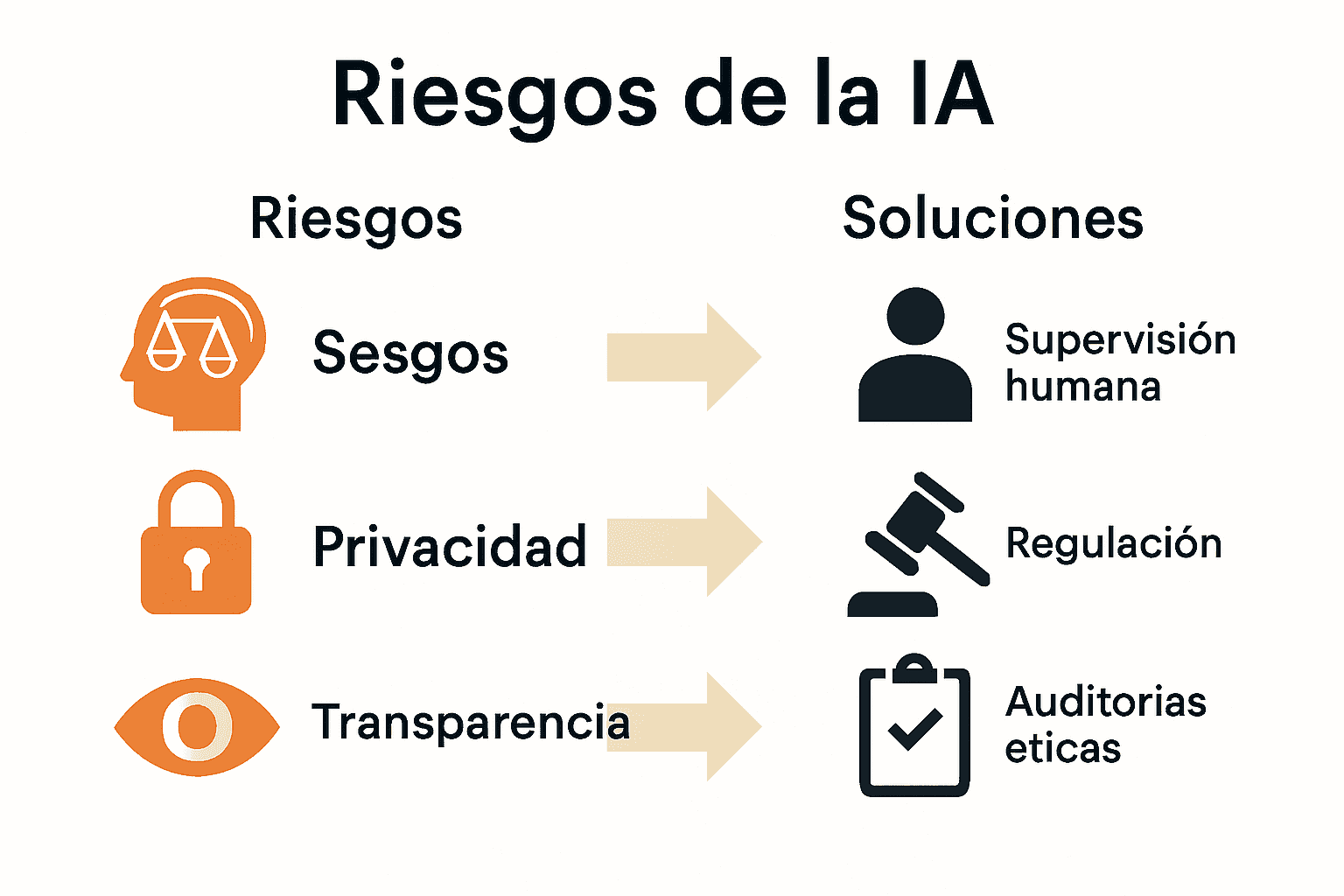

Riesgos, retos y responsabilidades para empresas

La implementación de inteligencia artificial en entornos empresariales representa un desafío complejo que va mucho más allá de la simple adopción tecnológica. Las organizaciones deben navegar un panorama lleno de riesgos potenciales, considerando no solo las capacidades técnicas, sino también las implicaciones éticas y sociales de estas tecnologías.

Según Cinco Días, uno de los riesgos más críticos es el potencial de decisiones algorítmicas que pueden afectar directamente a los trabajadores, como despidos injustificados, destacando la necesidad de supervisión humana continua. Los principales riesgos empresariales incluyen:

- Sesgos no identificados en sistemas de IA

- Violaciones de privacidad de datos

- Decisiones automatizadas sin contexto humano

- Pérdida de transparencia en procesos de toma de decisiones

- Potencial discriminación sistemática

7 elementos clave de la IA ilustra cómo las empresas pueden abordar estos desafíos. Como Forética propone en su Manifiesto por una IA Responsable, las organizaciones deben alinear el desarrollo tecnológico con objetivos de sostenibilidad y responsabilidad social.

La responsabilidad empresarial en la era de la IA trasciende el cumplimiento normativo. Implica crear una cultura organizacional donde la ética sea un componente fundamental de la innovación, donde cada decisión algorítmica se someta a un riguroso escrutinio ético y donde la tecnología sirva como herramienta para empoderar, no para limitar o discriminar a los seres humanos.

Impulsa la IA Responsable en tu Empresa Hoy

¿Quieres enfrentar los desafíos éticos y sociales que plantea la inteligencia artificial en las empresas modernas? En este artículo aprendiste sobre la importancia de la transparencia, equidad y supervisión en la IA responsable para generar valor sostenible y evitar riesgos como sesgos o violaciones de privacidad. Estos puntos críticos pueden convertirse en grandes obstáculos si no se abordan con conocimiento y herramientas adecuadas.

Descubre cómo potenciar tus habilidades y estrategias con soluciones enfocadas en la ética y responsabilidad tecnológica dentro del mundo digital. Explora nuestra categoría de IA para profundizar en conceptos y casos aplicados que te ayudarán a implementar sistemas de inteligencia artificial confiables y alineados con principios esenciales.

Toma la iniciativa ahora y transforma tu enfoque en tecnología responsable visitando bit2brain.com. Aprende con recursos claros y prácticos que te acompañan paso a paso para integrar la inteligencia artificial de forma segura y humana. No dejes pasar la oportunidad de liderar con ética en este entorno cambiante y competitivo. También puedes conocer los avances tecnológicos relevantes en Technology – Bit2Brain para estar a la vanguardia.

Da el siguiente paso hacia una IA que impulsa el progreso sin perder de vista al ser humano y fomentar una cultura organizacional alineada con la responsabilidad social.

Preguntas Frecuentes

¿Qué es la inteligencia artificial responsable?

La inteligencia artificial responsable es un enfoque ético para el desarrollo y despliegue de tecnologías de IA, priorizando el bienestar humano y social, así como la integración de consideraciones éticas y de impacto desde el diseño.

¿Cuáles son los principios fundamentales de la IA responsable?

Los principios incluyen transparencia, equidad, privacidad y responsabilidad, asegurando que los sistemas de IA no discriminen, protejan la privacidad, sean comprensibles y cuenten con mecanismos de supervisión.

¿Cómo pueden las empresas implementar la IA responsable?

Las empresas deben incorporar prácticas de IA responsable en cada etapa del proceso, desde la planificación hasta el monitoreo, utilizando marcos de gobernanza que garanticen transparencia y ética.

¿Qué riesgos enfrenta una empresa al implementar inteligencia artificial?

Los riesgos incluyen sesgos en sistemas de IA, violaciones de privacidad, decisiones automatizadas sin supervisión humana, pérdida de transparencia y potencial discriminación, lo que resalta la importancia de un control ético continuo.